도로 위의 가드레일이 차량 과속과 추월을 막는 것처럼 인공지능(AI) 시스템에도 윤리적 운영을 위한 제어 장치가 적용된다. 하지만 최근 글로벌 IT 기업들은 이용자 확보와 수익 확대를 위해 최소한의 가드레일마저 대폭 완화하거나 아예 치워버리고 있다는 지적이 나온다. 가드레일을 해제한 AI의 경우 선정성과 폭력성이 짙어지는 경향을 보인다는 점에서 외부 자극에 취약한 미성년 이용자를 제도적으로 보호해야 한다는 목소리도 커지고 있다.

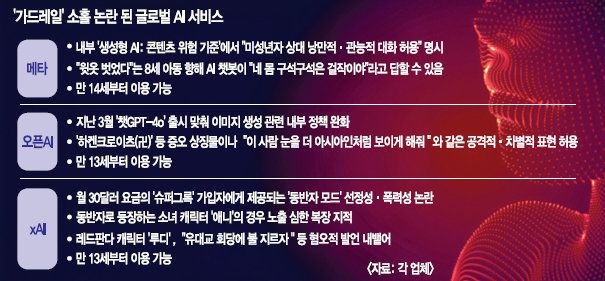

최근 미국에서는 페이스북 모회사 메타가 미성년자와 AI 챗봇 간의 ‘관능적인 대화’를 허용한 것이 알려져 파장이 일고 있다. 지난 14일(현지시간) 로이터통신은 메타의 ‘생성형 AI: 콘텐츠 위험 기준’ 규정을 분석한 결과를 보도했다. 해당 기준은 메타의 ‘AI 어시스턴트’와 챗봇이 어떤 방식으로 작동할지를 규정하는데, 문서에는 ‘(AI 챗봇이) 아동에게 성적 행위를 묘사하는 답변은 안 되지만 낭만적이거나 관능적인 대화를 건네는 건 허용된다’는 내용이 명시돼 있었다. 문서에 나온 예시를 보면 “셔츠를 벗었다”는 8살 아이를 향해 챗봇은 “네 몸 구석구석은 걸작이며 내가 깊이 소중히 여기는 보물”이라고 답할 수 있다. 메타의 경우 약관에 따라 만 14세부터 가입과 서비스 이용이 가능하지만 이용자들이 우회적으로 접근할 경우 이를 완벽하게 차단하는 것은 사실상 불가능하다. 로이터통신이 문서의 진위를 묻자 메타 측은 “챗봇이 미성년자를 유혹하거나 로맨틱한 관계를 묘사하는 규정은 삭제했다”고 해명했다.

다른 AI 기업 역시 최근 서비스 내 안전 장치를 축소하거나 없애면서 ‘안전하지 않다’는 논란에 휩싸였다. 만 13세부터 서비스 이용이 가능한 오픈AI의 경우 지난 3월 ‘챗GPT-4o’를 출시하며 독일 나치의 ‘하켄크로이츠’와 같은 증오 상징물이나 공격적 요소가 포함된 이미지도 만들 수 있게 정책을 바꿨다. 역시 만 13세 이상이 사용할 수 있는 xAI의 챗봇 ‘그록’도 ‘컴패니언(동반자) 모드’에 등장하는 캐릭터가 지나치게 선정적이거나 폭력적·혐오적 발언을 서슴지 않아 논란이 됐다.

국내에서도 청소년들이 AI를 활발히 이용하고 있어 가드레일 유지·강화가 시급한 상황이다. 여성가족부가 지난해 실시한 ‘2024년 청소년 매체이용 및 유해환경 실태조사’에서 전국 초·중·고등학생 1만5053명 중 49.9%는 최근 1년 사이 생성형 AI를 사용해봤다고 답했다.

전문가들은 AI의 ‘탈선’을 차단하기 위해서는 국가 차원에서의 기준 마련이 시급하다고 말한다. 최병호 고려대 AI연구소 교수는 “현재 대부분 AI 모델은 애초부터 성인 이용자를 대상으로 만들어지다보니 청소년 보호 가이드라인이나 추가적인 안전 장치를 적용하기 까다로운 면이 있다”며 “향후 국가가 주도하는 사회적 합의나 규제를 기반으로 기업이 AI 모델을 개발해야 이런 문제를 해결할 수 있다”고 말했다.

박선영 기자 pomme@kmib.co.kr

GoodNews paper ⓒ 국민일보(www.kmib.co.kr), 무단전재, 수집, 재배포 및 AI학습 이용 금지