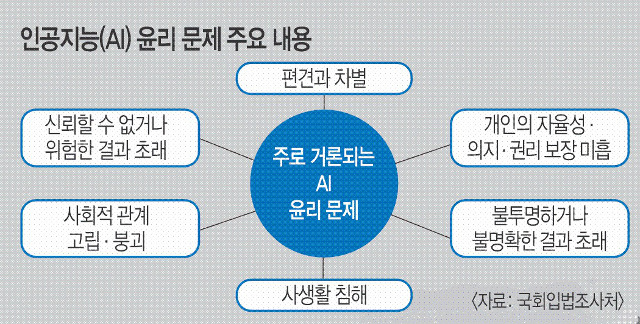

지난 5월 22일(현지시간) 미국 주식시장이 사진 한 장에 출렁였다. 미 펜타곤(국방부) 옆 건물이 불타는 사진이 소셜미디어에서 삽시간에 퍼지면서다. 스탠더스앤드푸어스(S&P)500지수가 0.3% 눌렸고, 다우존스산업평균지수는 80포인트 빠졌다. 하지만 이 사진은 인공지능(AI)이 만들어낸 가짜 사진으로 밝혀졌고, AI 기술의 비윤리적 사용에 대한 우려가 제기됐다.

AI를 악용하면 범죄 문제로도 번질 수 있다. 지난 4월 해외의 한 엑스(X·옛 트위터) 이용자는 디스코드의 AI 챗봇인 클라이드봇이 ‘폭탄 제조법’을 알려줬다고 전했다. 이 X 이용자가 네이팜탄(소이탄) 제조법을 알려 달라고 하자 AI가 친절하게 설명했다는 것이다. 주요 AI에는 정보 거름망인 윤리 기준이 프로그래밍돼 있지만 폭탄 제조 사례는 이를 우회하는 것이 가능하다는 점을 확인시켜줬다.

AI 윤리 측면에서 지적받는 또 다른 문제로 ‘환각’ 현상이 있다. 생성형 AI가 실제로는 없거나 사실이 아닌 정보를 그럴듯하게 꾸며내는 것을 말한다. 이 현상은 전문지식을 요구하는 분야에서 두드러진다. 해당 지식을 가진 사람이 소수인 데다 검증도 쉽지 않기 때문이다. 국제 의학전문학술지 ‘큐리우스’는 올해 1월 챗GPT로 의학 논문을 작성하는 대회를 열었는데 왜곡된 정보 탓에 챗GPT를 실제 연구에 쓸 수 없다는 결론이 나왔다.

생성형 AI를 둘러싼 윤리 문제가 AI 기술 발전의 속도를 따라가지 못한다는 지적이 계속되는데도 글로벌 빅테크 기업들은 AI 윤리 조직을 축소하거나 없애고 있다. 지난 3월 AI 윤리팀을 없앤 마이크로소프트(MS)가 대표적이다. 구글, 메타, 엑스, 아마존 등은 윤리조직의 규모를 줄였다. 언론 인터뷰나 콘퍼런스 등 공식석상에서는 “AI 윤리와 안정성에 힘쓸 것”이라고 발표하지만 실제로는 정반대 행보를 보이는 상황이다.

오픈AI 공동창업자이자 대표이사(CEO)인 샘 올트먼이 잠시나마 해고됐던 배경에도 AI 개발 목적에 대한 견해차가 있었다. 올트먼은 AI 기술을 발전시키면서 사업성을 키우는 데 집중했다. 오픈AI는 ‘인간에게 가장 안전하고 유익한 AI의 개발’에 중점을 뒀고, 이런 관점에서 AI 개발에 앞장선 이들 사이에서 올트먼은 위험한 인물이라는 지적까지 나왔다.

기업의 자정 노력이 부족한 가운데 최근 미국은 AI 기술 오용을 막기 위한 행정명령을 내렸다. AI가 국가안보, 경제, 공중보건 등에 위험을 초래하지 못하도록 정부의 관리·감독을 강화하는 조치다. 유럽연합(EU)은 지난 6월 세계 최초로 ‘AI 규제법’을 통과시켰다.

전문가들은 AI를 제대로 육성하기 위해서라도 규제가 필요하다고 말한다. 전창배 국제인공지능윤리협회 이사장은 “한국이 AI 악용 가능성을 막으면서 성장 주도권을 가지려면 AI 기본법이 통과돼야 한다”고 주장했다.

한명오 기자 myungou@kmib.co.kr

GoodNews paper ⓒ 국민일보(www.kmib.co.kr), 무단전재, 수집, 재배포 및 AI학습 이용 금지